问题描述

我已经使用ubuntu的内置apt cuda安装的第二个答案here在我的ubuntu 16.04中安装了tensorflow。

现在我的问题是我该如何测试tensorflow是否真的在使用gpu?我有一个gtx 960m gpu。当我import tensorflow这是输出

I tensorflow/stream_executor/dso_loader.cc:105] successfully opened CUDA library libcublas.so locally

I tensorflow/stream_executor/dso_loader.cc:105] successfully opened CUDA library libcudnn.so locally

I tensorflow/stream_executor/dso_loader.cc:105] successfully opened CUDA library libcufft.so locally

I tensorflow/stream_executor/dso_loader.cc:105] successfully opened CUDA library libcuda.so.1 locally

I tensorflow/stream_executor/dso_loader.cc:105] successfully opened CUDA library libcurand.so locally

这个输出足以检查tensorflow是否正在使用gpu吗?

最佳方法

不,我认为“开放式CUDA库”不足以说明问题,因为图形的不同节点可能位于不同的设备上。

要找出使用哪个设备,您可以启用日志设备放置,如下所示:

sess = tf.Session(config=tf.ConfigProto(log_device_placement=True))

检查您的控制台是否有这种类型的输出。

次佳方法

除了使用其他答案以及官方TensorFlow documentation中概述的sess = tf.Session(config=tf.ConfigProto(log_device_placement=True))之外,您还可以尝试将计算分配给gpu,看看是否有错误。

import tensorflow as tf

with tf.device('/gpu:0'):

a = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0], shape=[2, 3], name='a')

b = tf.constant([1.0, 2.0, 3.0, 4.0, 5.0, 6.0], shape=[3, 2], name='b')

c = tf.matmul(a, b)

with tf.Session() as sess:

print (sess.run(c))

这里

-

“/cpu:0″:您计算机的CPU。

-

“/gpu:0″:计算机的GPU(如果有)。

如果您有GPU并可以使用它,则将看到结果。否则,您将看到堆栈跟踪较长的错误。最后,您将获得以下内容:

Cannot assign a device to node ‘MatMul’: Could not satisfy explicit device specification ‘/device:GPU:0’ because no devices matching that specification are registered in this process

最近,一些有用的功能出现在TF中:

-

tf.test.is_gpu_available告知GPU是否可用

-

tf.test.gpu_device_name返回gpu设备的名称

您还可以在会话中检查可用设备:

with tf.Session() as sess:

devices = sess.list_devices()

devices将为您返回类似

[_DeviceAttributes(/job:tpu_worker/replica:0/task:0/device:CPU:0, CPU, -1, 4670268618893924978),

_DeviceAttributes(/job:tpu_worker/replica:0/task:0/device:XLA_CPU:0, XLA_CPU, 17179869184, 6127825144471676437),

_DeviceAttributes(/job:tpu_worker/replica:0/task:0/device:XLA_GPU:0, XLA_GPU, 17179869184, 16148453971365832732),

_DeviceAttributes(/job:tpu_worker/replica:0/task:0/device:TPU:0, TPU, 17179869184, 10003582050679337480),

_DeviceAttributes(/job:tpu_worker/replica:0/task:0/device:TPU:1, TPU, 17179869184, 5678397037036584928)

第三种方法

以下代码段应为您提供所有可用于tensorflow的设备。

from tensorflow.python.client import device_lib

print(device_lib.list_local_devices())

Sample Output

[name: “/cpu:0” device_type: “CPU” memory_limit: 268435456 locality { } incarnation: 4402277519343584096,

name: “/gpu:0” device_type: “GPU” memory_limit: 6772842168 locality { bus_id: 1 } incarnation: 7471795903849088328 physical_device_desc: “device: 0, name: GeForce GTX 1070, pci bus id: 0000:05:00.0” ]

第四种方法

我认为有一个更简单的方法可以实现这一目标。

import tensorflow as tf

if tf.test.gpu_device_name():

print('Default GPU Device: {}'.format(tf.test.gpu_device_name()))

else:

print("Please install GPU version of TF")

它通常打印像

Default GPU Device: /device:GPU:0

在我看来,这比那些冗长的日志更容易。

第五种方法

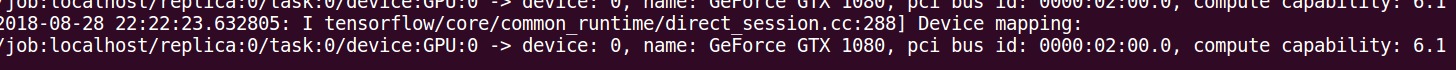

这是否可以确认使用GPU进行训练同时进行tensorflow吗?

码

sess = tf.Session(config=tf.ConfigProto(log_device_placement=True))

输出量

I tensorflow/core/common_runtime/gpu/gpu_device.cc:885] Found device 0 with properties:

name: GeForce GT 730

major: 3 minor: 5 memoryClockRate (GHz) 0.9015

pciBusID 0000:01:00.0

Total memory: 1.98GiB

Free memory: 1.72GiB

I tensorflow/core/common_runtime/gpu/gpu_device.cc:906] DMA: 0

I tensorflow/core/common_runtime/gpu/gpu_device.cc:916] 0: Y

I tensorflow/core/common_runtime/gpu/gpu_device.cc:975] Creating TensorFlow device (/gpu:0) -> (device: 0, name: GeForce GT 730, pci bus id: 0000:01:00.0)

Device mapping:

/job:localhost/replica:0/task:0/gpu:0 -> device: 0, name: GeForce GT 730, pci bus id: 0000:01:00.0

I tensorflow/core/common_runtime/direct_session.cc:255] Device mapping:

/job:localhost/replica:0/task:0/gpu:0 -> device: 0, name: GeForce GT 730, pci bus id: 0000:01:00.0

第六种方法

Tensorflow 2.0

从tensorflow 2.0开始,不再使用会话。测试GPU功能的一种仍然有效的方法是:

import tensorflow as tf

assert tf.test.is_gpu_available()

assert tf.test.is_built_with_cuda()

如果出现错误,则需要检查安装。

第七种方法

除了其他答案,以下内容还应帮助您确保您的tensorflow版本包括GPU支持。

import tensorflow as tf

print(tf.test.is_built_with_cuda())

第八种方法

这应该给出可用于Tensorflow的设备列表(在Py-3.6下):

tf = tf.Session(config=tf.ConfigProto(log_device_placement=True))

tf.list_devices()

# _DeviceAttributes(/job:localhost/replica:0/task:0/device:CPU:0, CPU, 268435456)

第九种方法

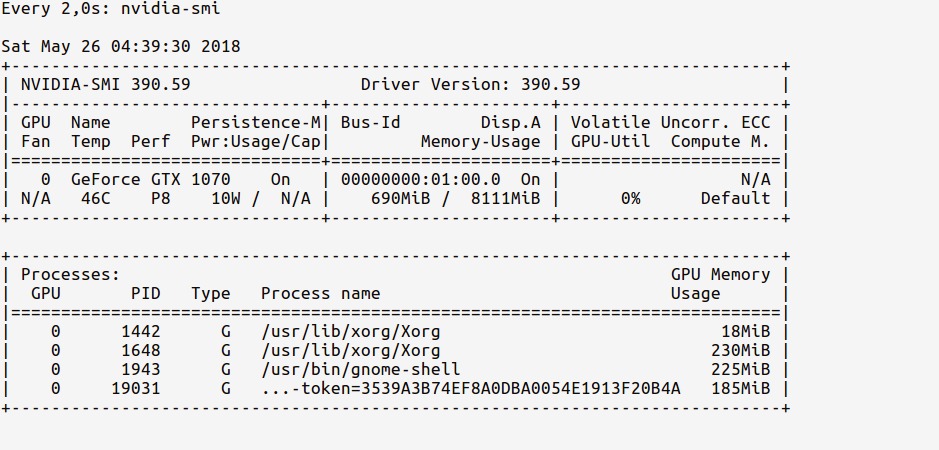

我更喜欢使用nvidia-smi来监视GPU使用情况。如果在开始编程时它显著上升,则表明您的张量流正在使用GPU。

第十种方法

好的,首先从终端启动ipython shell和import TensorFlow

$ ipython --pylab

Python 3.6.5 |Anaconda custom (64-bit)| (default, Apr 29 2018, 16:14:56)

Type 'copyright', 'credits' or 'license' for more information

IPython 6.4.0 -- An enhanced Interactive Python. Type '?' for help.

Using matplotlib backend: Qt5Agg

In [1]: import tensorflow as tf

现在,我们可以使用以下命令查看GPU内存使用情况:

# realtime update for every 2s

$ watch -n 2 nvidia-smi

由于我们只有import修改过TensorFlow,但尚未使用任何GPU,因此使用情况统计信息为:

观察一下GPU内存的使用量是如何非常少(〜200MB)的。

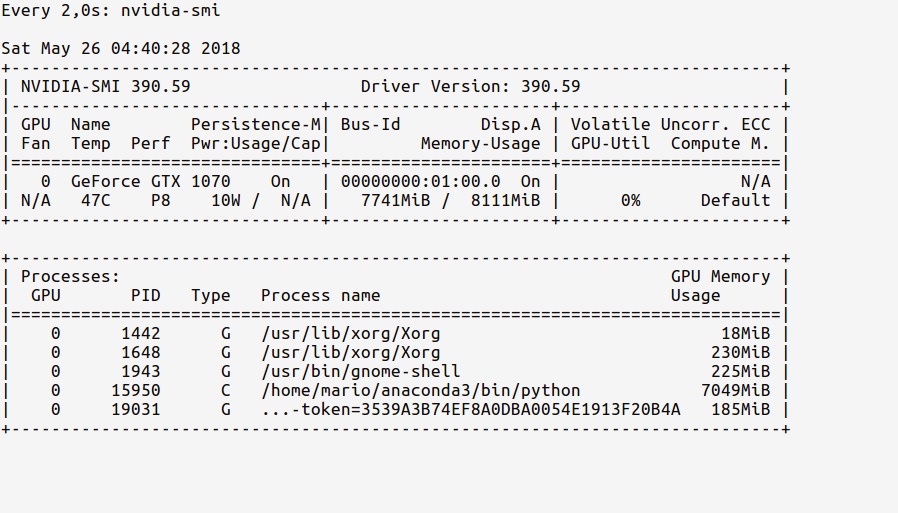

现在,让我们在代码中加载GPU。如tf documentation中所示,执行以下操作:

In [2]: sess = tf.Session(config=tf.ConfigProto(log_device_placement=True))

现在, watch 统计信息应显示更新的GPU使用情况内存,如下所示:

从ipython shell观察我们的Python进程如何使用7.7GB的GPU内存。

附言您可以在代码运行时继续观看这些统计信息,以了解GPU的使用强度。